一般社団法人AIガバナンス協会

業務執行理事 佐久間弘明

前回までは、HR領域におけるAIリスクの全体像を概観した上で、代表的なユースケースである「採用業務でのAI活用」におけるリスクを説明してきた。

今回は、二つ目のユースケースとして「評価(査定)業務でのAI活用」に焦点を当てる。評価業務におけるAI活用のメリットとデメリット、リスク事例、それへの対策について見ていきたい。その後、本連載の締めくくりとして、全体を振り返る。

評価業務におけるAI活用のメリットとリスク

採用業務における可能性と同様、評価や査定、また配置等に関する業務でも、AIには多様な用途が想定される。評価自体にAIを活用することは可能であるし、そもそもの評価ポリシーの策定や、人材の配置・異動に関する判断のサポート等でもAIによる分析や文章生成を生かすことができる。

人事評価は評価者による偏見などの属人的な要素が入り込みやすい業務であるため、採用と同様に、AIの活用が「嗜好に基づく差別」を防ぐ一助となり得る。実際に米国のHR関連事業者の調査によると、AIツールを利用する企業の管理職のうち半数以上が、部下の昇給や昇進の決定にAIを活用している。また、その他の関連業務についても社内の複雑な情報を処理する必要があるため、AI活用によって作業の質・速さの双方を向上させる余地は大きい。

こうした業務においては、外部の応募者の履歴書等を基に評価する採用業務と異なり、自社内の各ポジションの業務や対象者のこれまでの業績に関するより多様なデータを活用することとなる。こうしたデータの質と量が確保されなければ、AIガバナンス以前に、業務に関するデータの標準化や統合によってデータを使えるようにする「データマネジメント」と呼ばれる取り組みが重要となることには留意する必要がある。

では、評価業務におけるAIユースケースのリスクにはどのようなものがあるのだろうか。特に注意すべき点は「不当なバイアス」「ブラックボックス化」の2点である。

●不当なバイアス

第2回で解説したものと同型の問題である。AIを活用して社員個人の能力評価や配置決定を行う場合、その判断は対象者の人生に大きく影響するため、慎重な判断が求められる。人がそれらの判断を行う場合と比較して、AIの判断は個々人による「嗜好に基づく差別」を排除できる半面、「統計的差別」については悪化させてしまう可能性がある。例えば、特定の属性や行動の傾向を持つ社員に対して、本来の評価対象である業績以外のデータを基に不当に低い評価を下してしまうことがあり得る。

●ブラックボックス化

AIは確率的な推論によって出力を行うが、個々の出力の理由について詳細な説明を加えることは難しく、AIを活用した意思決定を事後的に検証することは困難になる。加えて「自動化バイアス」と呼ばれる傾向により、最終的な意思決定を行う人間は他の情報よりもAIの出力結果を過度に信用してしまうことが多い。こうしたことから、AIによる評価の仕組みはうまく設計しなければ、その適正感を失い、あるいは社員の成長機会を奪うことにつながってしまう。

例えば、低い評価をつけられた社員からすれば、当然今後のキャリア形成を見据えて自身の改善点等を把握したいはずだが、AIによる評価の理由が開示されなければ、その道は閉ざされてしまうだろう。また、評価者が評価結果自体を「AIのせい」にすることによって責任を回避するようなケースも想定され得る。もちろん、人間の判断も究極的にはブラックボックスではあるものの、少なくとも判断根拠やプロセスを示す責任が評価者に課される点が、AIによる評価とは全く異なる。この問題は、第1回に示した3類型のAIリスクの「責任関係のリスク」に分類されるものだ。

以上のとおり、AIで評価業務を代替することには、幾つかのAI特有のリスクが伴う。ここでは特に「ブラックボックス化」に注目して議論することとし、人事評価自体にAIを活用するケースについて見ていく。

AIのブラックボックス性が問題視された例:日本IBMにおける労使紛争

2019年8月、日本IBMは米国本社が開発したAI「Watson」を賃金査定のプロセスに導入すると発表した。同AIは、「市場におけるスキルの多寡」「主たる業務の専門性」「過去の昇給」などを含む40項目の評価要素を基にし、昇給率の提案など人事評価に関するアドバイスを管理職に提示する仕組みだった。

これに対して同社の労働組合(日本金属製造情報通信労働組合〔JMITU〕の日本アイビーエム支部。以下、組合)は、①プライバシー侵害、②公平性と差別の問題、③ブラックボックス化、④自動化バイアスの四つの問題点を指摘し、団体交渉において、AIが評価で考慮する項目や評価者への提案内容の開示などを要求。④については、実際に組合員が上司から、「AIの出力に従って給与変更を決定した」という説明を受けた事例が紹介されている。

この問題は東京都労働委員会において争われ、最終的には4年余りの係争の後、2024年8月に労使間の和解が成立することとなった。その際の合意事項では、日本IBMは以下の取り組みを実行することとされている。

(1)組合に対して、AIが考慮する40項目の評価要素を開示する

(2)上記の各項目の、賃金規定との間の関係性を説明する

(3)組合員への不利益決定(給与減額、低評価等)に対して疑義がある際に、AIの提案内容を必要な範囲で開示する

(4)評価方法について今後疑義が生じた際に、組合と誠意を持って協議する

これらの合意事項からも分かるとおり、本件は基本的には、日本IBM側がAIを活用する際のプロセスの透明化を行うことによって解決が志向されている。

この事例について、第2回同様「技術」と「コミュニケーション」の枠組みから分析してみよう。組合の挙げた四つの問題点のうち、主に③ブラックボックス化と④自動化バイアスにフォーカスして議論する。

技術の観点では、既に述べたAIモデルのブラックボックス性が重要な問題になる。社員に対する特定の取り扱い(昇給や減給等)をAIが決定・推奨する際、なぜその取り扱いが妥当なのかについてAIが説明することはできない。このため、特に不利益決定をされた社員について、評価の納得感の確保や改善機会の提供が難しくなってしまう。そして、それを助長するのが、人間がAIの決定を鵜呑みにしてしまう自動化バイアスだ。この事例では、評価者がAIが考慮する評価項目を十分に把握していなかったという問題も指摘されており、評価を受ける社員に適切なアドバイスやコーチングが行えていなかったおそれがある。

コミュニケーションの観点では、そもそもAIを賃金査定に用いることについて、組合から強い反対の意思が示されていること自体が注目される。指摘されている懸念事項からも分かるとおり、事前に十分な情報開示が行われていなかったと評価できる。特に問題があったと考えられるのは、「賃金査定に際して社員のどのようなデータが用いられ、どのような項目に落とし込んで評価がなされるのか」というプロセス・考慮要素が不透明だった点だ。加えて、運用において、不利益取り扱いを受けた社員に対する配慮などにも改善の余地があったように思われる。

これらの技術とコミュニケーションの問題は、組合の挙げた①プライバシー侵害、②公平性と差別の問題とも連動している。すなわち、プライバシー侵害や不当なバイアスにさらされるおそれがある場合にも、どのような学習データを利用しているのかや、それを基にどのような理由で評価が行われたのかについて説明できなければ、最終的に問題の検証が不可能になってしまうということだ。このため、AIのブラックボックス性は、他のAIリスクの解決を難しくする横断的な問題としても捉えることが必要である。

評価AIに求められるガバナンス

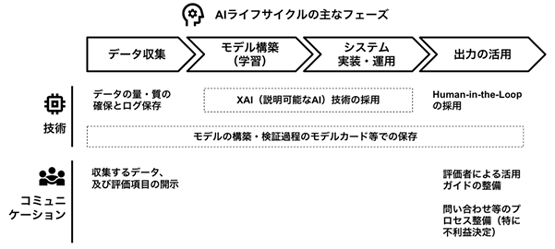

ここからは、以上の視点に沿ってAIを用いた評価システム(以下、評価AI)に求められるガバナンス施策を検討していこう[図表1]。前回同様、AIのライフサイクルをベースに対策を検討することが重要である。ブラックボックス性の問題に絞って見ていくこととする。

[図表1]評価AIのブラックボックス性への対策(論点例)

●技術面での対策

「XAI(説明可能なAI)技術を採用すること」「ログやモデル情報の保存を徹底し、検証可能とすること」の2点が基調となる。

XAI技術とは、その名のとおりAIの出力について、その理由や影響した特徴量を説明する技術である。例えば個々の予測値に対する各特徴量の貢献度を示すSHAPや、モデルが予測全体において重視している特徴量を可視化するPermutation Importance等の多様な手法が存在する。採用可能な場合は、こうした技術を用いて、モデルの説明可能性を向上させることが推奨される。ただし、こうした技術も現状では実装が難しい場合があるほか、モデルの入出力の間の因果関係までは説明できないことには留意する必要がある。このため、基本的にはモデルの一定のブラックボックス性を認めた上で、いかにしてプロセス全体についての説明責任を確保するかがポイントとなる。

次に実施することが望ましいのは、データやモデルの情報管理である。例えばデータの来歴を記録したログや、モデルのアーキテクチャとテスト結果等をまとめたモデルカードを標準化して整備し、評価に用いるAIがどのようなデータを基に、どのようなテストとリスク管理措置を経て実装されているのかを明確にしておくことが望ましい。これにより、異議申し立てを受けた場合にも説明責任を果たすことが可能になる。

●コミュニケーション面での対策

特に管理職等の評価者と被評価者(評価を受ける社員)の間のコミュニケーションが重要になる。まず被評価者の観点では、日本IBMの事例でも最終的な和解事項に盛り込まれたように、評価AIが利用するデータの範囲や、具体的な評価項目について社内によく周知することが必要である。また、これらの評価項目を重視する理由等があらかじめ開示されることで、プロセスへの信頼感や納得感も高まる上、評価結果に対する解釈が加えやすくなり、被評価者の成長や納得感の向上にもつながるだろう。

次に、評価者に対しては、AIの技術的性質やその出力の性質について周知し、結果をどのように実際の評価に反映すべきかを徹底するためのガイド等の整備を行うことが重要である。先述のとおり、AIの入出力の間の因果関係を説明することは基本的に難しいため、AIの評価を踏まえて人間がHuman-in-the-Loopの考え方で再チェックをすることが望ましい。この際、自動化バイアスを避けるため、評価者がAIの出力を参考として用いつつ、自らの業務評価を踏まえて自らの責任の下で最終決定を行うといったフローを徹底すべきである。

また、被評価者に対しては、評価項目の開示に加えて、特に不利益決定がなされた際の問い合わせ等のチャネルを用意することが望ましい。実際に不当な決定を防げるだけでなく、評価者がAIの出力を批判的に検証するインセンティブにもなるだろう。

以上のとおり、人事評価等でAIを活用する場合、AIのブラックボックス性と向き合うことが不可欠になる。こうした技術的特性を踏まえつつ、社員の人生を左右する重要な決定に用いていることを常に意識し、説明責任をしっかりと果たせるプロセスを整備することが求められる。

「変わらぬ責任」をいかに果たすか

本連載では、まずAIガバナンスをめぐる全体像を概観した上で、「採用」「評価」という二つの代表的なユースケースについて、リスクとガバナンスの概要を説明してきた。大事なのは、結局のところ「採用候補者や社員の人権」「企業としての生産性」など、AI活用において実現すべき価値自体は、人間が採用プロセスを担う場合とさほど変わらないということだ。まさに本連載のタイトルとしているとおり、HRとして果たす責任そのものはAI活用においても異なるものではないので、それをいかに実現すべきかを検討することが必要である。

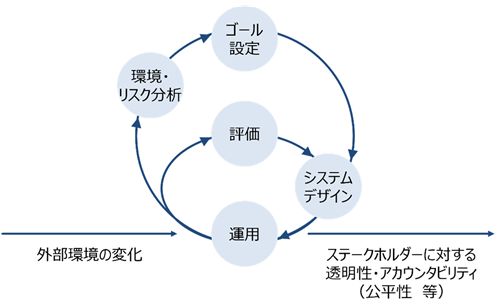

その際に大切なのは、マルチステークホルダーアプローチと、継続的な見直しの2点である。まず、AIの影響を受ける人々の多様な視点を踏まえ、対外的に説明可能なAIガバナンスプロセスをつくり上げること。そして、変化の激しい技術・政策環境を踏まえ、一度構築したガバナンス体制を過信せず不断に見直しを重ねていくこと。こうした努力が、企業のAI活用の鍵となるだろう。第1回で説明したアジャイル・ガバナンスの実装において最も重要な部分である[図表2]。

AIをめぐる激しい環境変化の中で単にリスクを恐れて踏みとどまるのではなく、しっかりとリスク管理を行った上で実装を進められるかどうかは、今後の企業にとって分水嶺となるだろう。本連載が、AI活用を目指すさまざまな企業のHR担当者のガバナンス構築の一助となれば幸いである。

[図表2]アジャイル・ガバナンスのイメージ

資料出所:経済産業省・総務省「AI事業者ガイドライン(第1.1版)」

|

佐久間弘明 さくま ひろあき 一般社団法人AIガバナンス協会 業務執行理事 経済産業省でAI・データに関わる制度整備・運用に従事したのち、Bain & Company Japan、Robust Intelligenceを経て現職。企業のAIガバナンス構築支援や、AI脅威インテリジェンス等の経験を多く持つ。AIガバナンス協会では、AIガバナンスをめぐる標準策定や政策提言などを行う。ほか、内閣官房デジタル行財政改革会議事務局政策参与(データ利活用制度検討担当)なども務める。また、社会学の視点でAIリスクをめぐる言説の研究にも取り組む。修士(社会情報学)。 |