一般社団法人AIガバナンス協会

業務執行理事 佐久間弘明

生成AIを中心とする人工知能(AI)の流行は、HR(人事)の仕事の輪郭を急速に書き換えつつある。履歴書のスクリーニングや面接質問の生成、社員のキャリア開発支援など、AIはさまざまな業務に効率化と高度化のチャンスをもたらす一方で、新たなリスクも生み出している。本連載では、HR領域におけるAI活用にどのような潜在的な可能性とリスクがあるのか、そしてそれに対処するためのガバナンスの在り方について、具体的なケースも踏まえて検討していく(全3回予定)。

第1回は、前提となるAI普及の背景やAI活用に付随するリスクの概要、社会的な議論の状況等をお伝えし、「AIガバナンス」を実装する際の基本的な考え方を紹介する。

「AI時代」の影響はHR領域にも

HR領域におけるAI活用は、いわゆる第3次AIブーム(ディープラーニングの社会実装が急速に進んだ2010年代)から徐々に進められてきた。過去の人事関連データを基に評価や採用を高度化するなどのいわゆる「予測系AI」のユースケースにおいても、さまざまな活用の機会が広がっていた。

そこにさらなるインパクトを与えているのが、「生成AI」の登場である。生成AIを代表する大規模言語モデルは、WEB上の膨大なデータ等を学習して自然な文章や画像を高精度で生成する。この生成AIが急速に普及している要因は、大きく3点ある。第1は性能向上の速度であり、従来のAIモデルを大きく凌駕する推論能力を持つモデルが次々とリリースされていることは周知のとおりだろう。第2は活用の裾野の広さだ。専門的なプログラム言語を用いず自然言語の入力だけで操作できるため、これまでプログラミング等に触れてこなかった非エンジニアの人材も容易に活用できる。第3は用途の汎用性であり、同じ基盤モデルを基にRAG(検索拡張生成)やファインチューニングといった手法で調整を行うことにより、幅広いサービスへの適用が可能となる。

2025年にはOpenAIやGoogleからこれまで以上に高度なモデルが登場し、リアルタイムの音声・画像処理や長文分析が可能になったため、HRの現場でも「候補者との模擬面接を自動実演し、その場で評価する」ような高度な機能が現実味を帯びつつある。

HR領域での活用と効果

具体的に、HR領域のAIユースケースにはどのようなものがあるのだろうか。例えば採用では、応募書類の自動評価や面接質問生成によりプロセスを効率化したり、人間よりも公平な評価を行ったりするためにAIが活用できるかもしれない。HRテックベンダーも、生成AIを活用した採用アシスタント等を次々リリースしている。また、人材配置とキャリア開発の観点では、社員のスキルや実績データをAIが分析し、最適な部署配置や研修計画を提示することも考えられる。その他、社内チャットボットは就業規則や福利厚生の問い合わせを即時に処理し、人事担当者の負荷を減らすことに寄与するかもしれない。直近では、これらの業務をより高度に自動化するAIエージェントツールも登場している。

こうしたユースケースにおいてAIシステムの適切な設計を行えば、AIが人間の無意識のバイアスや非効率なプロセスを是正し、採用候補者や社員一人ひとりに合わせたデータドリブンな対応を実現できる可能性がある。しかし、これから述べるように、さまざまな「AIリスク」(AI活用に付随するリスク)も隣り合わせであることには注意が必要だ。

3類型のAIリスク

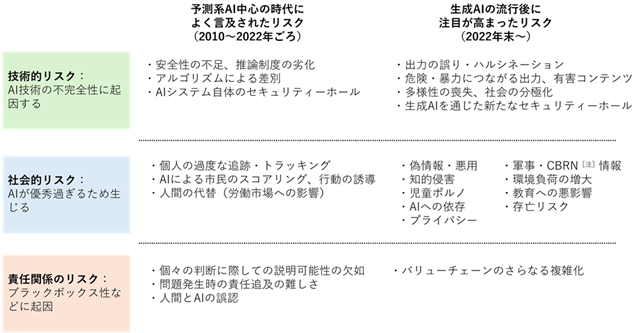

まず、AIリスクにどのようなものがあるのかを概観してみよう。さまざまな整理の方法があるが、ここでは「技術的リスク」「社会的リスク」「責任関係のリスク」の3点に分類して見ていきたい[図表1]。

[図表1]3類型のAIリスクの概観

[注]CBRN:化学(Chemical)、生物(Biological)、放射性物質(Radiological)、核(Nuclear)

「技術的リスク」は、その名のとおりAIの技術的な特性に起因して、望ましくない出力や挙動が行われてしまうリスクである。代表的なものは、ハルシネーション(生成AIが事実に基づかない誤った情報をもっともらしく生成すること)をはじめとする不正確な出力で、データドリフトと呼ばれる推論性能の劣化により正しい判断ができなくなるといった問題が想定される。また、採用や評価など対象者の人生を左右し得る重大な決定に用いられるAIにおいては、学習データの偏りやアルゴリズムの影響により差別的な出力が行われる問題も深刻だ。さらに、AIが悪意のあるユーザーによって攻撃を受けたりするおそれもある。

「社会的リスク」は、技術的な進歩によってAIの性能が「高くなり過ぎた」が故に発生し始めた問題である。有名なものは著作権侵害であり、既存のコンテンツを高度に模倣できることが新たな問題を生んでいる。その延長上には、AIによる労働代替が生む失業などの問題もあるだろう。また、AIを通じた精密な行動予測や、学習に用いられた個人データの再現も可能であり、プライバシー侵害等の懸念も生じている。高品質な偽情報やディープフェイクの生成も重大な問題だ。AIが人間らしい挙動をするために、人間がそれを過度に信頼したり、心理的に依存してしまったりする事態も広がりつつある。

「責任関係のリスク」は、いわゆるAIのブラックボックス性に起因するものだ。AIモデルは内部構造が複雑で、「なぜ、ある出力が行われたのか」を特定することが難しい。このため、トラブルが発生した際に原因の特定が難しく、開発者、ベンダー、ユーザー等のステークホルダーのいずれが責任を負うべきかが曖昧になりやすい。これにより、「技術的リスク」や「社会的リスク」を通じて発生した損害の被害者がうまく救済されないといった事態が発生する。

以上のとおり、AIのビジネスにおける活用はさまざまなメリットとリスクを私たちにもたらしている。企業が活用を進める場合には、こうしたリスクへの対応を適切に行い、ステークホルダーからの信頼を確保することが不可欠になるだろう。

世界の規制動向

このように、AI活用に付随するさまざまなリスクが指摘される中で、各国もAIの規制や、リスク対策のための枠組みの整備を進めている。ここでは、特にHR領域への影響に注目しながら、2025年6月現在の状況を概観してみよう。

EUはよく知られるとおり、基本的にはAIのもたらす基本的人権への影響などに着目し、法規制を基調とする対応を進めてきた。2024年5月に成立した「AI法」では、AIのユースケースごとのリスク度合いに着目して、段階的に異なる義務を課している。求人広告のターゲティング、採用、労働者のパフォーマンス評価といったHRの主要な業務で用いられるAIシステムについては、4段階のリスク度合いのうち上から2段目の「ハイリスクなAIシステム」に分類されており、品質管理システムの整備、適合性評価や透明性確保等が義務づけられている(「ハイリスク」AIに関する規律は2027年の施行を予定)。EU域内で上記のAIシステムを提供する企業であれば日本企業も対象となり、違反時には制裁金が科されることになる。なお、このAI法自体は今後全面施行に向けた検討が続くことになるが、EU域内ではAI規制の見直しを迫る声が上がっていることも注目される。2024年9月に公開された「欧州の競争力の未来」と題された報告書(通称「ドラギレポート」)では、EUの競争力強化のためにAI法が障壁となることなどが指摘され、実際に同法の手続き緩和の議論も進められている。

米国は、連邦レベルでの包括的なAI規制法等は存在せず、バイデン政権期には主に生成AI基盤モデルに特に着目したリスク管理政策が進められてきた。「AIの安心、安全で信頼できる開発と利用に関する大統領令」や、大手AI開発者との間の自主誓約がこれに当たる。その後、トランプ政権における政策転換で同大統領令に掲げられた政策の見直しが進められるなど、生成AIをめぐる規律が後退していることは周知のとおりだ。ただし、HRに関わる領域については生成AIの流行前から、規制やガイドラインの整備が進められている。2023年にニューヨーク市では採用AIに対する規制条例が導入され、「自動雇用決定ツール」と呼ばれるソフトウエアを活用する企業に対して「バイアス監査」(性別や人種等に基づくバイアスが含まれていないかについて、第三者による監査を受け、結果を公表すること)を義務づけられている。また、同時期に連邦レベルでも、雇用機会均等委員会(EEOC)のガイダンスが発表され、採用におけるAIツールにバイアスが存在する場合、違法となる可能性があることが指摘されている。

日本では、HR領域のAI活用に着目した規制は存在せず、基本的には非拘束的なガイドラインを基調とした政策対応が進められてきた。2024年には、従来存在したAIガバナンスに関するガイドライン類について生成AIの流行も踏まえて統合・改定した「AI事業者ガイドライン(第1.1版)」が経済産業省・総務省から発行され、企業がAI活用の際に順守すべき基本的な指針やそのための取り組み例が示された。また、政府に設置された「AI戦略会議・AI制度研究会」での議論を踏まえ、2025年の通常国会に「人工知能関連技術の研究開発及び活用の推進に関する法律案」(通称「AI法案」)が提出され、5月28日に可決・成立し、6月4日に公布されている。ただし、同法は規制法ではなく、企業向けの罰則付きの規律は存在しない。基本的には政府の体制整備や「基本計画」の策定、政府によるAIに関する指針の整備、情報収集権限などを定めたものである。今後は同法を起点に、上記「基本計画」等で政府の政策方針がより具体的に示されていくことが予想されるため、引き続き注目しておくべきだろう。

なお、本稿ではAI活用に着目した規律に絞って紹介しているが、AI活用の結果であっても、既存法で禁じられた行為が行われる場合には問題となることに注意が必要だ。例えば、人間であってもAIであっても、採用において不当な差別を行うことは許されない。前述の米国EEOCのガイダンスはまさにその例であり、日本においても個人の採用に関わる規制として、男女雇用機会均等法、職業安定法の差別禁止規定などが適用され得る。

AIガバナンスの重要性とポイント

AIに関わる技術的・政策的環境は日々劇的に変化しており、HR領域を含め企業にとってのAI活用のメリットは大きく、ユーザーにとってもさまざまな利便性がもたらされるのだから、この機会を逃す手はない。企業は高い不確実性の中で、AIをめぐるメリットとリスクを見極め、意思決定を行っていかなければならない難しい局面に置かれている。そこで、AIのリスクを低減するとともに、対外的な説明責任を果たすことで、AIのもたらす価値を最大化する取り組み=「AIガバナンス」が不可欠となる。

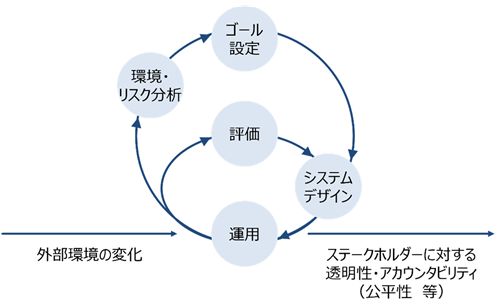

AIガバナンスを考える上でまず意識すべきは、「アジャイル・ガバナンス」の考え方である。これは前述の「AI事業者ガイドライン」でも推奨されているガバナンスモデルであり、事前にルールまたは手続きを完全に固定するのではなく、「環境・リスク分析」「ゴール設定」「システムデザイン」「運用」「評価」といったサイクルを継続的に回転させていくという考え方を取る[図表2]。

変化の激しいAIをめぐる情勢の下では、「昨日の常識」が「今日の非常識」となっている場合さえある。その際、固定的なルールだけに頼ってAIシステムを運用していると、思わぬところでリスクが顕在化したり、逆に保守的に構え過ぎて活用に過度なブレーキがかかってしまったりする。AIシステムの運用の中で認識される新たなリスクや、環境分析から見える新たなトレンドを敏感に捉え、常に自社のガバナンスをアップデートしていく姿勢が求められる。その際、企業の内部だけでもHR、事業、技術開発、IT、法務、コンプライアンスなど多様な関係者が存在する上、AIシステムの影響を受ける外部ステークホルダーも幅広いため、「マルチステークホルダー」の発想でそれらの異なる立場からの意見を取り入れていくことも重要だ。

[図表2]アジャイル・ガバナンスのイメージ

資料出所:経済産業省・総務省「AI事業者ガイドライン(第1.1版)」

それでは、より具体的にリスク対策を考える際、どのような視点で臨めばよいのだろうか。重要になるのは、「技術」と「コミュニケーション」という二つの視点である。

まず、AIシステムは当然技術的な複雑性を持つシステムであるから、リスク対策において技術的な視点は不可欠だ。本連載でも今後見ていく予定だが、例えば学習データの質はAIシステムの出力と直結するし、AIのバイアスを低減したり、問題のある出力を防ぐための「レッドチーミング」といった手法を取り入れたりすることも考えられる。こうした手法のどれを、どのようなリスクに対応するために適用するのか、検討していく必要がある。

ただし、技術的な対策だけですべてのリスクに対応できることは基本的にはあり得ない。AIシステムはあくまで人が開発し、人が使うものだ。さまざまなステークホルダーに必要な情報をインプットする、契約などの手段で事前に運用方法と責任の所在を決めておくなど、人同士・組織同士でのコミュニケーションもAIガバナンスの重要な要素となる。

今回は、AI一般におけるリスクとガバナンスをめぐるポイントを概観した。リスクの認識においてもガバナンスの構築においても、重要になるのはAIシステムを「社会技術システム」、すなわち技術とさまざまな人の間の相互作用の中で運用されていくシステムとして捉えることだ。

次回以降は実際にこの視点を導入し、HR領域でも主要なタスクである「採用」と「人事評価」を取り上げて、具体的なリスク事例や必要な対策について検討していきたい。

|

佐久間弘明 さくま ひろあき 一般社団法人AIガバナンス協会 業務執行理事 経済産業省でAI・データに関わる制度整備・運用に従事したのち、Bain & Company Japan、Robust Intelligenceを経て現職。企業のAIガバナンス構築支援や、AI脅威インテリジェンス等の経験を多く持つ。AIガバナンス協会では、AIガバナンスをめぐる標準策定や政策提言などを行う。ほか、内閣官房デジタル行財政改革会議事務局政策参与(データ利活用制度検討担当)なども務める。また、社会学の視点でAIリスクをめぐる言説の研究にも取り組む。修士(社会情報学)。 |