一般社団法人AIガバナンス協会

業務執行理事 佐久間弘明

第1回では、HR領域におけるAI活用の可能性と、それを取り巻く「技術的リスク」「社会的リスク」「責任関係のリスク」(3類型のAIリスク)の概要、そしてAIガバナンスの基本的な考え方について概観した。

今回は、その中でも特にHR領域の有効なユースケースとして注目される「採用業務でのAI活用」に焦点を当てる。採用業務におけるAI活用の具体的なメリットとデメリット、さらに顕在化したリスク事例から得られる教訓、そしてそれに対する具体的なガバナンス手法について、前回提示した「技術」と「コミュニケーション」の両観点から掘り下げていきたい。

採用業務におけるAI活用のメリットとリスク

採用業務においては、さまざまなAIユースケースが存在する。求人票や面接質問の自動生成など、純粋な内部業務にもAIによる効率化の余地があるし、候補者の選定プロセスもAIで高度化が可能である。特に、履歴書のスクリーニングや面接による評価といった、候補者の選定に密接に関わる業務でAIを活用する場合を想定して議論したい。

ここでは上記のような業務におけるAI活用のメリットとリスクを見ていくが、重要なのは、AIが人間のバイアス(偏り)を減少させ得る側面も、増幅させ得る側面もあるということだ。学術的な研究においては、「差別」に関して「嗜好に基づく差別」と「統計的差別」の2類型があるとされている※。前者は「特定の属性の人が気に食わない」「特定の属性の人は能力が低い」といった、人間が持つ根拠のない直感や偏見に基づいた判断を指すのに対し、後者は過去の集団に関するデータに基づいて、個々の人間の性質を無視して判断を下すことを指す。

AI活用のメリットは、これらのうち前者の「嗜好に基づく差別」を排除できることだ。すなわち、人間による評価において入り込むさまざまな偏見を排除し、職務適性をよりしっかりと見極めた公平な選考を行える可能性がある。また付随して、単純に人間の担当者では疲れや時間の問題から処理能力に限界があり、正確な判断を続けることが難しいのに対して、AIにはそのような制約がない点もメリットだ。実際に、適切に設計されたAIモデルが選定した候補者は、人間の採用担当者が選定した候補者よりも数倍、選考に通過しやすいという研究もある。このようなポテンシャルを生かすことができれば、単純な省力化も含め、大きなメリットがもたらされるはずだ。

他方、採用におけるAI活用にはリスクもある。特に不当なバイアスが結果に反映されるリスクには注意したい。先ほどの分類の中では、「統計的差別」の問題が懸念される。AIによる採用判断は基本的に、過去の同一企業や同一業界における人事データに基づいて学習したモデルによって行われる。しかし、こうした過去のデータの傾向から個別の候補者に対して判断を下すことは、その個人が持つ能力や特性を無視することにつながるし、根拠となるデータ自体が偏っている場合も多い。例えば、2014年にアマゾン社が開発した採用AIツールにおいては、最終的にAIの判断で男女差別が行われていることが問題となり運用が停止された。この例では、過去10年間におけるエンジニアへの応募者の履歴書データがAIの学習に用いられたが、過去の応募履歴がほぼ男性で占められていたために、こうしたバイアスが発生したとされている。この問題は、3類型のAIリスクの中では、「技術的リスク」に分類される。

以上のとおり、AIは「嗜好による差別」を防ぎ、人間よりも効果的かつ効率的な判断を行う可能性を持つ一方、「統計的差別」を反映するなどのリスクもある。こうした背景もあり、採用用途のAIがEUのAI法で「ハイリスクなAIシステム」に分類されていることは前回述べたとおりである。

※五十嵐 彰『可視化される差別——統計分析が解明する移民・エスニックマイノリティに対する差別と排外主義』(新泉社)

統計的差別が問題視されているWorkdayの訴訟

AI活用のリスクが顕在化した典型的な事例として、米国のHRテック企業であるWorkdayに対する訴訟が挙げられる。

同社は、履歴書や性格診断テストの結果などを基に応募者をふるい分ける採用スクリーニングAIツールを多数の企業に提供していた。しかし、2023年に提起された訴訟では、同社が提供する採用AIツールが、黒人や障害者、40歳以上といった属性を持つ人々を不当に高い割合で不採用にしていると主張された。アフリカ系アメリカ人の原告は、十分な学歴と職歴を持っているにもかかわらず、同社のシステムを採用する100社近くの選考においていずれも不採用となり、応募後ほぼ即時に不採用が通知された事例もあったという。この訴訟は現在、求職者による集団訴訟に発展し、係争中である。なお最新の報道では、雇用における年齢差別禁止法に基づく請求が条件付きで認定されている。潜在的にこの採用AIツールの影響を受けた人々は数億人に上るため、今後米国史上最大規模の集団訴訟に発展する可能性もあるという。

この事例から学べることは何だろうか。以下では、前回も提示した「技術」と「コミュニケーション」の枠組みから分析してみたい。

まず技術の観点だが、前述のとおり、AIツールは過去の同一企業や同一業界における人事データを学習するため、データに含まれる属性上の偏りをそのまま出力に反映しやすい。しかし、採用選考のような個人の権利・利益に重大な影響を及ぼす決定にAIの出力を活用する際には、その目的に関連するデータによって判断を行うことが国際的なガイドライン(OECDプライバシー原則の「データ内容の原則」など)でも要請されている。職務能力と直接関連しない人種や年齢、障害の有無などの属性に基づく決定は、不当な差別とみなされ得るといえるだろう。

さらに事態を複雑にするのが「代替指標」の問題である。たとえ「性別」や「人種」といったバイアスに配慮すべき属性(保護属性)をデータから除外したとしても、AIモデルは「住んでいる地域」や「部活動歴」「専攻分野」「職歴」といった、保護属性と相関する別の指標(代替指標)を基に、実質的に偏りのある推論を行う可能性がある。実際に前述のアマゾン社の採用AIツールの事例でも、経歴に書かれる「女子チェス部」といった部活動から性別が推論され、差別の対象となったとされている。

コミュニケーションの観点では、まず責任の所在が重要である。Workdayの訴訟では、裁判所がツールベンダーである同社を雇用主の「代理人」とみなせると判断したため、直接の雇用主ではなく同社の責任が問われている。しかし、第三者の採用AIツールを用いた雇用主自身も、差別的な決定が行った場合には当然に責任を問われる。バリューチェーン上のどのようなプレーヤーも、こうしたリスクに目を向ける必要があるのだ。

また、特に不採用となる候補者への手続き的な配慮という視点も考慮すべきだ。Workdayは訴訟において、日常的な採用業務に同社自身は関与しておらず、雇用主がコントロールしていたと主張している。しかし、このために不採用の通知がなされた後の候補者による異議申し立て等も実質的に機能していなかったと考えられる。AI自体を開発したWorkdayと、雇用主(ユーザー)である企業のどちらも候補者に対する手続き的なケアができない状態だったのだ。

Workdayの訴訟は係争中ではあるものの、以上のとおり本件から学べることは多い。それでは、具体的に採用でAIを活用する際には、どのようなことに気をつければよいのだろうか。

採用AIに求められるガバナンス

以下では、具体的なAIリスク対策を考える際に重要な「技術」と「コミュニケーション」の視点に沿って、採用AIに求められるガバナンス施策を検討していこう。

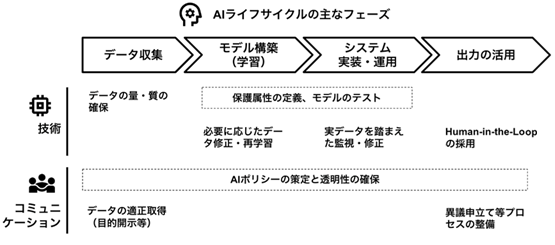

[図表]採用AIツールの活用における主なリスク対策(論点例)

「技術」の視点では、データ収集やモデル学習のフェーズにおいて対策を取ることが重要である。大前提として、データの代表性が不足していたり、偏りがあったりすれば当然AIモデルにも反映されるため、データの質・量を確保することが必要だ。

加えて、自社の採用において差別が許されない属性(保護属性)を設定した上で、モデル構築時および運用中に繰り返しモデルのテストを行うことが重要である。テストにより、保護属性ごとに極端な選択率の差異などが生じていないかを確認することで、代替指標を踏まえた上でのバイアスの度合いを把握できる。これを踏まえてもし問題があれば、データの修正・再学習等のプロセスを通じて、バイアスを是正することになる。システムの運用開始後は、事前の学習データやテストデータだけでなく実際の候補者のデータも増えていくため、それを踏まえた定期的な見直しも必要だ。

なお、ここでは基本的にAIが自動で合否の判断まで行う場合を想定しているが、そもそも「不合格となった候補者についてのみ人が再審査を行う」といった設計(Human-in-the-Loop〔HITL〕)を行うことも一案である。これにより、合格となる候補者に割いていたリソースの削減と、バイアスのリスク低減を両立することが可能になる。

次に「コミュニケーション」の視点では、まずシステム運用の大前提になるAIポリシーやAI開発のためのルールの整備、そしてその適切なレベルでの開示が必要だ。AIポリシーでは、自社がどのような考え方でAIを活用しているのか、どのようなバイアスを許されないものと捉えているのかといった点を明らかにすることで、対外的な信頼性の確保につながるだろう。また、そうした理念的なレベルの目標を実現するための具体的な取り組み事項についても可能な範囲で開示し、AIポリシーが絵に描いた餅に終わっていないことを説明することが望ましい。

その上で重要なのは、実際に出力結果を活用する際のプロセス整備である。具体的には、データの利用目的、および利用範囲の開示や、特に不利益な取り扱いをされた候補者による異議申し立てチャネルの整備が求められる。候補者は自ら選んでAIサービスを活用するのではなく、あくまで一方的に影響を受ける形になるため、事前の情報開示と、AIの判断に対する事後的な異議申し立ての余地を確保することが欠かせない。

以上のとおり、技術とコミュニケーションのそれぞれの視点から、採用AIのリスク対策が可能である。これらの対策はあくまで一時的なものであることを念頭に、定期的に現場の声や技術的な条件の変化を確認しつつ、アジャイルにルールや運用をアップデートしていくことが重要だ。

今回は、採用業務でのAI活用におけるリスクとガバナンスをめぐるポイントを概観した。採用は候補者の人生を左右する重要な決定に関わる業務であるため、適切なガバナンスを整備した上でAI活用を進めることが望ましい。次回は「人事評価」のユースケースについて、同様の分析・整理を行っていく。

|

佐久間弘明 さくま ひろあき 一般社団法人AIガバナンス協会 業務執行理事 経済産業省でAI・データに関わる制度整備・運用に従事したのち、Bain & Company Japan、Robust Intelligenceを経て現職。企業のAIガバナンス構築支援や、AI脅威インテリジェンス等の経験を多く持つ。AIガバナンス協会では、AIガバナンスをめぐる標準策定や政策提言などを行う。ほか、内閣官房デジタル行財政改革会議事務局政策参与(データ利活用制度検討担当)なども務める。また、社会学の視点でAIリスクをめぐる言説の研究にも取り組む。修士(社会情報学)。 |